作者 | 青暮

NeurIPS 2020 於12月6日至12月12日在線上舉行,除了論文演講以及各大workshop之外,競賽也是企業和高校爭奪榮譽和進行學術交流的一大平臺。

在今年的NeurIPS賽場上,AI科技評論發現了一個頗有意思的競賽:參賽者始終不知道目標任務是什麼,但還是要憑藉開發的算法在這些任務上爭奪第一名,並且開發過程中只能收到極少量的反饋信息。難道,這是要讓選手開發通用智能算法?當然不是。此外值得一提的是,選手最終提交的代碼也不能自己運行,得交給競賽組織方去跑。

參賽選手的這種境地,就好像在賽車中不知道地形,就得決定選用什麼車,並選定自動駕駛方案,選定了自動駕駛方案後,就只能聽之任之,沒有任何幹預機會。在賽車過程中,選手也是完全摸黑在跑,組織方偶爾會告訴選手當前有沒有跑對路線。怎麼樣,是不是感覺很摸不著頭腦?

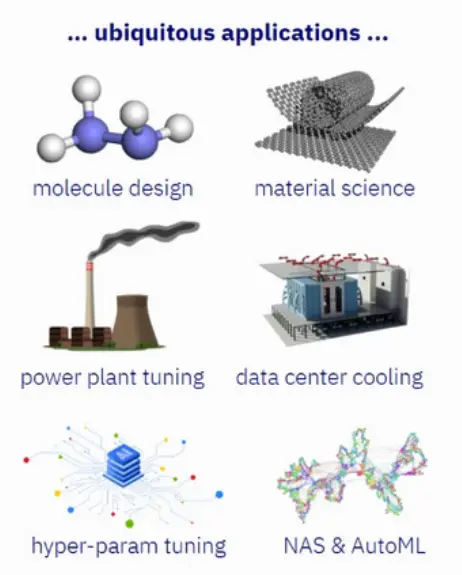

謎底揭曉:實際上,他們挑戰的任務叫做“黑盒優化”。黑盒優化與AutoML、超參數優化相關,比如網格搜索、貝葉斯優化就是常見的黑盒優化算法。由於黑盒優化幾乎與所有機器學習算法(特別是深度學習)以及機器學習之外的許多應用程序中的超參數調整都息息相關,因此這一競賽有著廣泛的影響。

除了AutoML和超參數優化以外,黑盒優化在分子設計、材料科學、電廠調試、數據中心冷卻、芯片設計等問題上也有著大量應用。

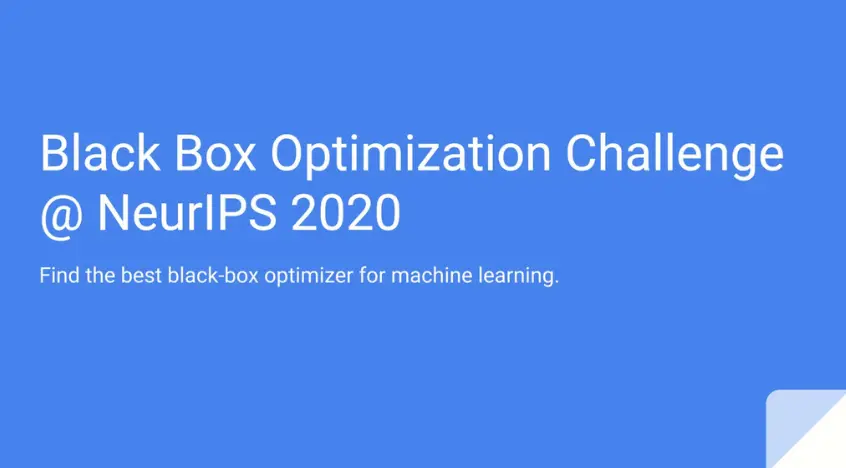

這場競賽名為NeurIPS2020 “Black box optimization for machine learning”(以下簡稱black box競賽),由Twitter、Facebook、SigOpt、Valohai及第四範式共同舉辦,組織方表示,“這項競賽旨在探索貝葉斯優化在AI模型調優中的最佳實踐。”

賽事共有來自全球的70支隊伍參賽,包括來自NVIDIA、IBM、Jetbrain、牛津大學的研究人員。競賽於7月1日開始,最終方案的提交截止日期為10月15日,獲獎名單則於11月15日公佈。

華為諾亞方舟實驗室團隊在本次競賽中獲得冠軍,團隊成員來自華為在深圳、北京、倫敦的研究所。華為獲得的總得分是93.519,而隨機搜索算法的總得分是75.404。

競賽最終排行榜

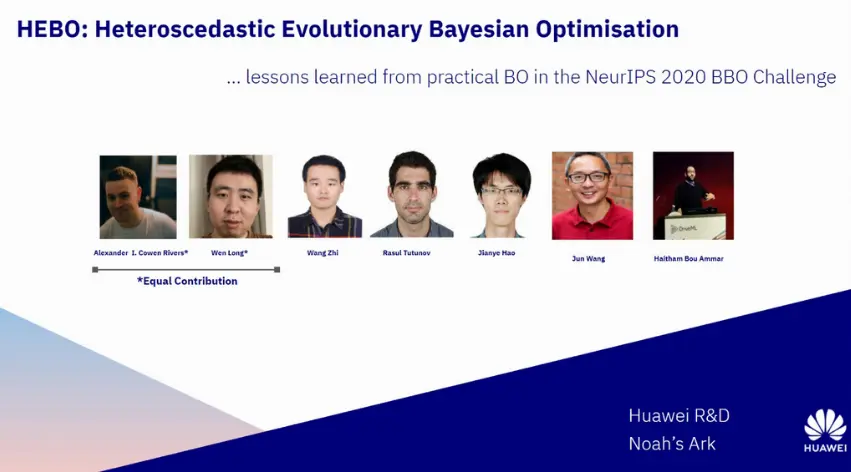

以下是此次參賽的團隊成員,包括來自華為諾亞方舟實驗室總部的決策與推理實驗室首席科學家汪軍,決策與推理實驗室主任郝建業,研究員呂文龍、王智,以及來自實驗室歐洲分部即華為倫敦研究所的研究員Alexander I. Cowen-Rivers、Rasul Tutunov、Haitham Bou Ammar。

1

黑盒優化是什麼

那麼黑盒優化是什麼概念呢?我們就從超參數優化的角度來解釋。大部分機器學習算法都擁有超參數,這些超參數可以分為兩種類型,即定義模型及結構本身的參數,以及目標函數與優化算法(求解器)所需的參數。前者用於訓練和預測階段,後者只用於訓練階段。

超參數的確定一般是通過在訓練時先人工設定初始值,然後通過反覆試驗迭代更新,從而獲得好的設置,該過程耗費的時間和人力成本是巨大的。如何確定超參數的值成為了AutoML中的重要問題,其核心是自動搜索最優超參數值,從而最大化預期目標。因此這個問題可以抽象化為函數極值問題,其中優化變量為超參數,函數值為機器學習模型的性能指標。

黑盒優化問題的目標函數的表達式未知,只能根據離散的自變量取值得到對應的目標函數值。超參數優化就屬於黑盒優化問題,我們在優化過程中只能得到函數的輸入和輸出,而無法知道優化目標函數的表達式以及梯度信息,這給超參數優化帶來了困難。

在某些機器學習模型中,超參數數量較大,是高維優化問題。模型的評估,也就是計算目標函數的值在很多情況下成本非常高,因為需要以某種超參數配置訓練機器學習模型,然後在驗證集上計算指標。

常用的超參數優化方法有網格搜索(Grid Search)、隨機搜索(Random Search)、遺傳算法、貝葉斯優化(Bayesian Optimization)等。

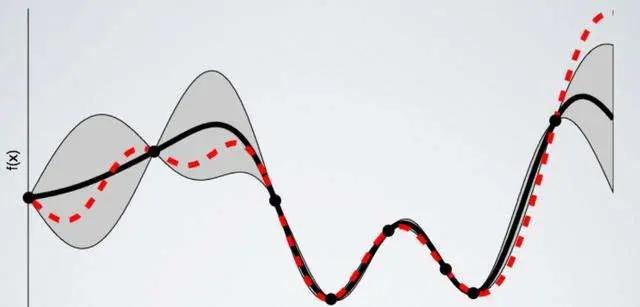

貝葉斯優化是一種流行的高效採樣方法,可對目標函數進行無導數優化,評估過程需要幾分鐘或幾小時才能完成。貝葉斯優化為目標函數建立了一個代理模型(通常是高斯過程),該模型提供了不確定性的度量。通過該代理模型,可以使用採集函數來確定最有希望評估的點。

貝葉斯優化有許多應用,機器學習模型的超參數調整(例如,深度神經網絡)是最流行的應用之一。然而,代理模型的選擇和獲取函數的選擇都與問題相關,而這場競賽的目標是對大量不同問題進行不同方法的比較,並集中於貝葉斯優化在機器學習模型的超參數調優中的應用。

具體來說,這場競賽的目的在於:

證明貝葉斯優化相對於隨機搜索和網格搜索(仍然很常用)的優越性;

尋找能夠並行的方法,這對於工業應用很有意義;

開發open loop優化器;

尋找簡單的提升方法(易於部署)。

2

只有16次迭代機會

在這場“摸黑賽車”競技中,參賽選手面對的困難非一般的機器學習競賽可比。

black box競賽的benchmark採用基於實際應用的機器學習超參優化問題。競賽組織者提供了108個基於sklearn中模型及數據的超參調優任務供參賽者調試代碼,但線上leaderboard的目標任務對參賽者保密。

對每個黑箱優化任務,待優化的參數包括整數、連續數值、布爾類型以及枚舉類型。參賽算法只有16次迭代探索機會,在每次探索中需要給出8組並行配置,每次迭代算法運行時間限制為不超過40秒。參賽者有3個月的時間迭代他們的算法。

對於線上benchmark,參賽者需將代碼提交至競賽網站,算法在競賽方虛擬環境中運行、評分。競賽任務對參賽者完全黑盒,參賽者無法得知算法將在何種目標任務運行,也不知道待優化參數的維度以及參數類型。排行榜將根據對隱藏目標函數的優化性能來確定,優化程序必須無需人工幹預即可運行。

在算法迭代過程中,競賽網站僅顯示算法在參賽任務上的評分,除此之外無法獲得其他信息(在算法運行出錯時,會顯示算法拋出的異常數,但並無報錯信息)。

競賽組織方使用了基於AutoML挑戰工作流和Bayesmark軟件包構建的基準測試系統。基線則基於六個開源黑盒優化軟件包的默認設置和隨機搜索進行設置。

汪軍表示,“這次競賽主要的困難來自目標任務的完全黑盒狀態,以及只有16次的限時迭代。這對算法及代碼實現均提出較高要求。一方面要求算法具有較強通用性,從而在完全未知的黑箱任務上具備泛化性;另一方面,因為在線上運行時即使算法出錯也不會有報錯信息,代碼實現必須保證穩健,亦需注意算法的數值穩定性問題。”

為解決上述問題,華為一方面採用諸如input warping,MACE等技術提升算法泛化性能,使模型動態適應高噪聲、非平穩的目標函數;另一方面,在模型訓練時,通過對GP參數設置先驗分佈來提高模型穩定性。

此外,通過對框架中主要的方面進行非常精細的檢查,華為發現,這裡面最關鍵的兩個地方是:對輸入的幹擾噪聲不平衡進行必要的處理,以及根據不同的任務來通過演化算法進行優化。

3

冠軍方案——河伯

華為將其算法框架命名為HEBO(Heteroscedastic Evolutionary Bayesian Optimization,異方差演化貝葉斯優化)。

HEBO系統由Haitham、郝建業、汪軍帶隊開發,首次出戰即通過團隊在魯棒的優化方法上的積累獲得成功。

HEBO讀作“河伯”,團隊取這個名字並不單純是出於英文首字母提取的常規考慮,而是有著自己的“小心思”,他們還特地為此設計了logo。

汪軍解釋道:“河伯是黃河之神,我們取這個名字的寓意,是形容貝葉斯優化的曲線(或函數空間)就像黃河之水,而黃河之水有足夠的勢能去越過局部最優點,最後找到全局最優點。由於黑箱優化存在較大的不確定性,河伯這個名字也有著祈禱的寓意。”

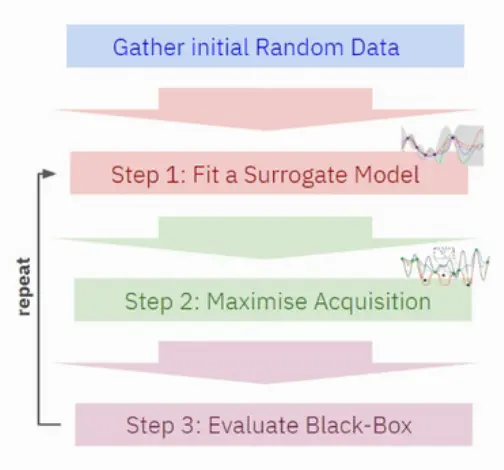

接下來我們簡單展開HEBO框架。一般而言,黑盒優化方法都需要經過以下步驟實現:

蒐集初始隨機數據;

擬合一個代理模型;

最大化採集函數;

評估黑箱算法。

具體來說,華為採用了貝葉斯優化中常用的高斯過程模型(Gaussian process, GP)作為代理模型,為解決non-stationary objective問題,引入input warping以及power transformation。

此外,研究者還提出了MACE(Multi-objective ACquisition function Ensemble),將貝葉斯優化中通用的EI、PI、UCB採集函數進行聚合,在這三種採集函數的帕累託前沿上進行採樣,一方面避免單一採集函數的通用性問題,另一方面支持並行探索。

最後,研究者引入基於模型噪聲的exploration方案,進一步提高探索效率,BO算法收斂至高性能區域後,根據目標任務噪聲水平做自適應隨機探索。

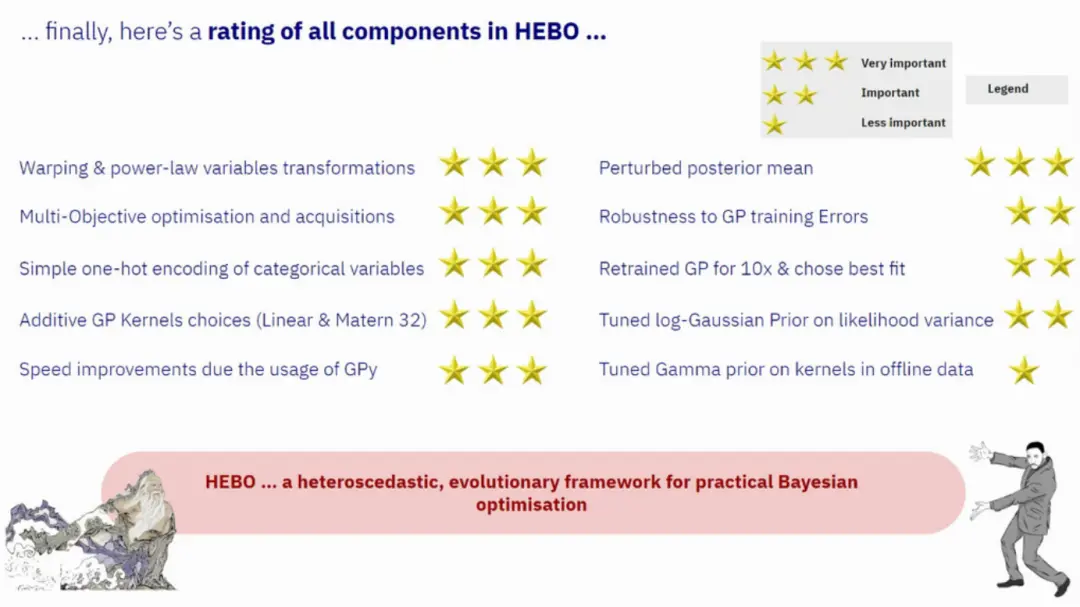

以下,華為總結了HEBO的不同組件的重要性。從三顆星到一顆星依次表示非常重要、重要、不太重要。這對解決實際任務有重要指導意義。

順便簡單提一下競賽方案的總體情況。據組織方統計,排名Top-10的參賽隊伍中有9個都使用了貝葉斯優化,並且有6個擴展了信頼域貝葉斯優化。

此外,參賽隊伍還總結出,混合方法比單獨使用一種方法要好得多,並且採用以下方式實現混合方法能獲得較高的效率:

對每個建議使用不同GP kernel;

分別對一個優化器和另一個優化器採用50%的點;

考慮一個優化器的集合,並使用Thompson採樣來識別最好的優化器;

用多個採集函數求解一個多目標的優化問題。

4

相關技術已落地

在這上百個優化任務的AI超參優化問題上,華為開發的算法顯示了較強的競爭力,最終獲得總分第一名。

華為並沒有滿足於競賽上的名次搶奪,實際上,貝葉斯優化技術在華為已經有了廣泛的應用。汪軍表示,“除傳統機器學習模型超參調優之外,貝葉斯優化還被應用於數據中心節能、無線多頻段參數調優、自動駕駛、芯片設計優化等業務領域,是實現決策智能的一個非常廣譜的工具。”

數據是信息時代的基石,5G、雲計算及AI的發展也使數據中心面臨更高的能耗挑戰,對此,華為諾亞方舟實驗室提出數據驅動的優化方案,根據數據中心環境進行動態調優,在保障冷卻效果的同時有效降低數據中心能源消耗。

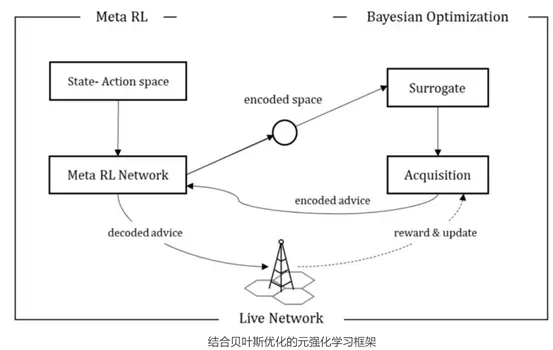

無線蜂窩網絡由大量無線基站構成,不同基站因其所處環境、所服務用戶不同,往往需要不同的基站配置以達成最佳用戶體驗,然而,一個城市可能有成千上萬個基站,依賴人工經驗的基站調優既需要耗費大量人力成本,也難以保證調優質量。對此,諾亞方舟實驗室聯合無線產品線,採用黑盒優化、強化學習等AI算法,自適應感知基站環境並對其調優。

汪軍提到,“諾亞方舟實驗室在數據驅動的優化方面,具有較強的技術積累及落地場景,同時,深圳、北京、倫敦同事組成的國際化團隊使得大家得以集思廣益。”

郝建業還提到,他們參加這場競賽的初衷,是希望對諾亞實驗室開發的優化器的通用性進行驗證,同時促進貝葉斯優化領域團隊交流,提升諾亞方舟實驗室的學術影響力。

華為諾亞方舟實驗室

華為諾亞方舟實驗室成立於2012年,是華為公司從事人工智能基礎研究的實驗室,在深圳、香港、北京、上海、西安、北美和歐洲等城市設有分部。該實驗室以長期的、有影響力的研究為驅動,致力於推動人工智能領域技術的創新和發展,併為華為的產品和服務提供技術支持。諾亞方舟實驗室的研究方向包括計算機視覺、自然語言處理、搜索推薦、決策推理、人機交互、AI理論、高速計算等。

在理論研究方面,諾亞方舟實驗室聚集了來自全球頂尖高校、優秀企業的研究員,同時與全球10+國家、25+大學、1000+研究人員保持連接。

2019年諾亞方舟實驗室在各頂會中成績斐然:CVPR 27篇、ICCV 19篇、AAAI 15篇、NeurIPS 7篇、ACL 6篇、 ACMMM 5篇,同時在2019 ACL上獲唯一最佳長論文。在2020年的CVPR上,有39篇論文被接受。

在應用創新方面,諾亞方舟實驗室聚焦於人工智能技術在各場景,包括網絡智能、企業智能、終端智能、自動駕駛等新興領域的應用,幫助公司解決商業場景中的挑戰問題。

華為倫敦研究所

華為倫敦研究所成立於2018年,主體是諾亞方舟實驗室在歐洲的分部。倫敦研究所致力於AI基礎研究,包含計算視覺、強化學習、自然語言處理、深度學習理論等研究方向。

參考資料:

https://bbochallenge.com/virtualroom

轉載請超鏈接註明:頭條資訊 » 目標任務都不知道,還讓我去競爭SOTA?記華為諾亞奪冠NeurIPS黑盒優化比賽

免責聲明

:非本網註明原創的信息,皆為程序自動獲取互聯網,目的在於傳遞更多信息,並不代表本網贊同其觀點和對其真實性負責;如此頁面有侵犯到您的權益,請給站長發送郵件,並提供相關證明(版權證明、身份證正反面、侵權鏈接),站長將在收到郵件24小時內刪除。