作者 | HelloGitHub-秦人

來源 | HelloGitHub(ID:GitHub520)

HelloGitHub 推出的《講解開源項目》系列,今天給大家帶來一款開源 Java 版一款網頁元素解析框架——jsoup,通過程序自動獲取網頁數據。

項目源碼地址:https://github.com/jhy/jsoup

項目介紹

jsoup 是一款 Java 的 HTML 解析器。可直接解析某個 URL 地址的 HTML 文本內容。它提供了一套很省力的 API,可通過 DOM、CSS 以及類似於 jQuery 選擇器的操作方法來取出和操作數據。

jsoup 主要功能:

從一個 URL、文件或字符串中解析 HTML。

使用 DOM 或 CSS 選擇器來查找、取出數據。

可操作 HTML 元素、屬性、文本。

使用框架

2.1 準備工作

掌握 HTML 語法

Chrome 瀏覽器調試技巧

掌握開發工具 idea 的基本操作

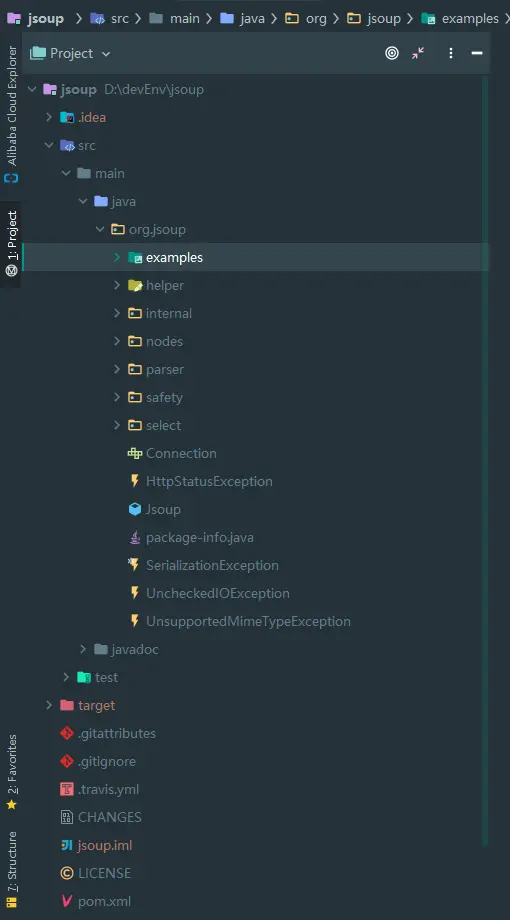

2.2 學習源碼

將項目導入 idea 開發工具,會自動下載 maven 項目需要的依賴。源碼的項目結構如下:

快速學習源碼是每個程序員必備的技能,我總結了以下幾點:

閱讀項目 ReadMe 文件,可以快速知道項目是做什麼的。

概覽項目 pom.xml 文件,瞭解項目引用了哪些依賴。

查看項目結構、源碼目錄、測試用例目錄,好的項目結構清晰,層次明確。

運行測試用例,快速體驗項目。

2.3 下載項目

git clone https://github.com/jhy/jsoup

2.4 運行項目測試代碼

通過上面的方法,我們很快可知 example 目錄是測試代碼,那我們直接來運行。注:有些測試代碼需要稍微改造一下才可以運行。

例如,jsoup 的 Wikipedia 測試代碼:

public class Wikipedia {

public static void main(String[] args) throws IOException {

Document doc = Jsoup.connect("http://en.wikipedia.org/").get();

log(doc.title());

Elements newsHeadlines = doc.select("#mp-itn b a");

for (Element headline : newsHeadlines) {

log("%s\n\t%s", headline.attr("title"), headline.absUrl("href"));

}

}

private static void log(String msg, String... vals) {

System.out.println(String.format(msg, vals));

}

}

改造後可運行的代碼如下:

public static void main(String[] args) throws IOException {

Document doc = Jsoup.connect("https://www.baidu.com/").get();

Elements newsHeadlines = doc.select("a[href]");

for (Element headline : newsHeadlines) {

System.out.println("href: " +headline.absUrl("href") );

}

}

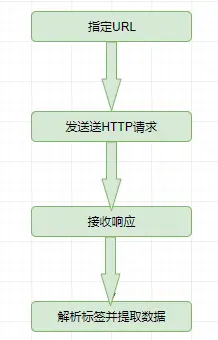

工作原理

Jsoup 的工作原理,首先需要指定一個 URL,框架發送 HTTP 請求,然後獲取響應頁面內容,然後通過各種選擇器獲取頁面數據。整個工作流程如下圖:

以上面為例:

3.1 發請求

Document doc = Jsoup.connect("https://www.baidu.com/").get();

這行代碼就是發送 HTTP 請求,並獲取頁面響應數據。

3.2 數據篩選

Elements newsHeadlines = doc.select("a[href]");

定義選擇器,獲取匹配選擇器的數據。

3.3 數據處理

這裡對數據只做了一個簡單的數據打印,當然這些數據可寫入文件或數據的。

實戰

獲取豆瓣讀書 -> 新書速遞中每本新書的基本信息。包括:書名、書圖片鏈接、作者、內容簡介(詳情頁面)、作者簡介(詳情頁面)、噹噹網書的價格(詳情頁面),最後將獲取的數據保存到 Excel 文件。

目標鏈接:https://book.douban.com/latest?icn=index-latestbook-all

4.1 項目 pom.xml 文件

項目引入 jsoup、lombok、easyexcel 三個庫。

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

4.0.0

org.example

JsoupTest

1.0-SNAPSHOT

1.8

1.8

org.jsoup

jsoup

1.13.1

org.projectlombok

lombok

1.18.12

com.alibaba

easyexcel

2.2.6

4.2 解析頁面數據

public class BookInfoUtils {

public static List getBookInfoList(String url) throws IOException {

List bookEntities=new ArrayList();

Document doc = Jsoup.connect(url).get();

Elements liDiv = doc.select("#content > div > div.article > ul > li");

for (Element li : liDiv) {

Elements urls = li.select("a[href]");

Elements imgUrl = li.select("a > img");

Elements bookName = li.select(" div > h2 > a");

Elements starsCount = li.select(" div > p.rating > span.font-small.color-lightgray");

Elements author = li.select("div > p.color-gray");

Elements description = li.select(" div > p.detail");

String bookDetailUrl = urls.get().attr("href");

BookDetailInfo detailInfo = getDetailInfo(bookDetailUrl);

BookEntity bookEntity = BookEntity.builder()

.detailPageUrl(bookDetailUrl)

.bookImgUrl(imgUrl.attr("src"))

.bookName(bookName.html())

.starsCount(starsCount.html())

.author(author.text())

.bookDetailInfo(detailInfo)

.description(description.html())

.build();

// System.out.println(bookEntity);

bookEntities.add(bookEntity);

}

return bookEntities;

}

/**

*

* @param detailUrl

* @return

* @throws IOException

*/

public static BookDetailInfo getDetailInfo(String detailUrl)throws IOException{

Document doc = Jsoup.connect(detailUrl).get();

Elements content = doc.select("body");

Elements price = content.select("#buyinfo-printed > ul.bs.current-version-list > li:nth-child(2) > div.cell.price-btn-wrapper > div.cell.impression_track_mod_buyinfo > div.cell.price-wrapper > a > span");

Elements author = content.select("#info > span:nth-child(1) > a");

BookDetailInfo bookDetailInfo = BookDetailInfo.builder()

.author(author.html())

.authorUrl(author.attr("href"))

.price(price.html())

.build();

return bookDetailInfo;

}

}

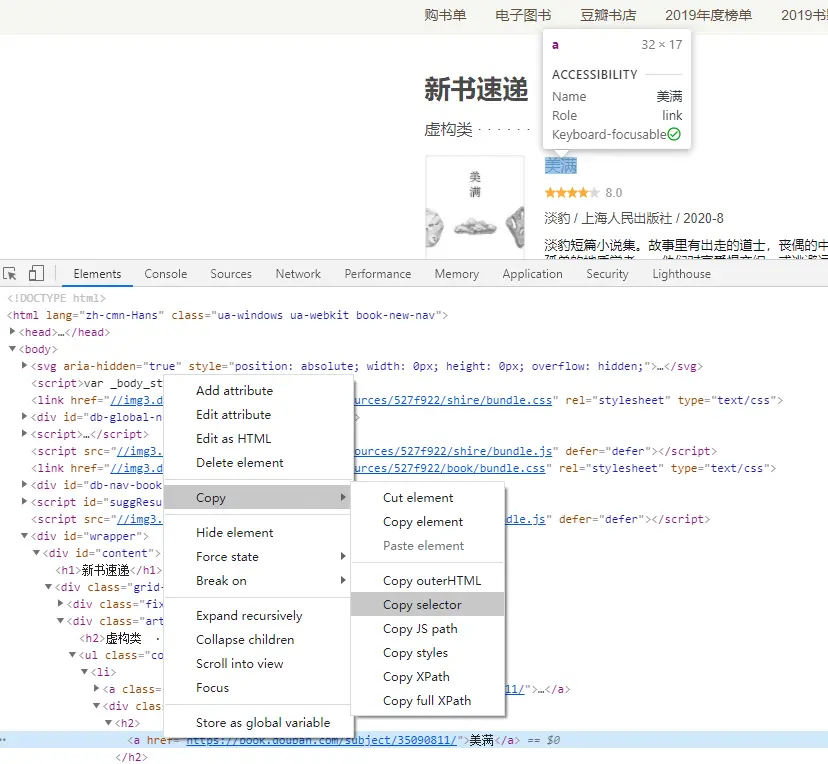

這裡的重點是要獲取網頁對應元素的選擇器。

例如:獲取 li.select("div > p.color-gray") 中 div > p.color-gray 是怎麼知道的。

使用 chrome 的小夥伴應該都猜到了。打開 chrome 瀏覽器 Debug 模式,Ctrl + Shift +C 選擇一個元素,然後在 html 右鍵選擇 Copy ->Copy selector,這樣就可以獲取當前元素的選擇器。如下圖:

4.3 存儲數據到 Excel

為了數據更好查看,我將通過 jsoup 抓取的數據存儲的 Excel 文件,這裡我使用的 easyexcel 快速生成 Excel 文件。

Excel 表頭信息

@Data

@Builder

public class ColumnData {

@ExcelProperty("書名稱")

private String bookName;

@ExcelProperty("評分")

private String starsCount;

@ExcelProperty("作者")

private String author;

@ExcelProperty("封面圖片")

private String bookImgUrl;

@ExcelProperty("簡介")

private String description;

@ExcelProperty("單價")

private String price;

}

生成 Excel 文件

public class EasyExcelUtils {

public static void simpleWrite(List bookEntityList) {

String fileName = "D:\\devEnv\\JsoupTest\\bookList" + System.currentTimeMillis() + ".xlsx";

EasyExcel.write(fileName, ColumnData.class).sheet("書本詳情").doWrite(data(bookEntityList));

System.out.println("excel文件生成完畢...");

}

private static List data(List bookEntityList) {

List list = new ArrayList();

bookEntityList.forEach(b -> {

ColumnData data = ColumnData.builder()

.bookName(b.getBookName())

.starsCount(b.getStarsCount())

.author(b.getBookDetailInfo().getAuthor())

.bookImgUrl(b.getBookImgUrl())

.description(b.getDescription())

.price(b.getBookDetailInfo().getPrice())

.build();

list.add(data);

});

return list;

}

}

4.4 最終展示效果

最終的效果如下圖:

以上就是從想法到實踐,我們就在實戰中使用了 jsoup 的基本操作。

完整代碼地址:https://github.com/hellowHuaairen/JsoupTest

最後

Java HTML Parser 庫:jsoup,把它當成簡單的爬蟲用起來還是很方便的吧?

為什麼會講爬蟲?大數據,人工智能時代玩的就是數據,數據很重要。作為懂點技術的我們,也需要掌握一種獲取網絡數據的技能。當然也有一些工具 Fiddler、webscraper 等也可以抓取你想要的數據。

教程至此,你應該也能對 jsoup 有一些感覺了吧。編程是不是也特別有意思呢?參考我上面的實戰案例,有好多網站可以實踐一下啦~

轉載請超鏈接註明:頭條資訊 » 用 Java 拿下 HTML,分分鐘寫個小爬蟲!

免責聲明

:非本網註明原創的信息,皆為程序自動獲取互聯網,目的在於傳遞更多信息,並不代表本網贊同其觀點和對其真實性負責;如此頁面有侵犯到您的權益,請給站長發送郵件,並提供相關證明(版權證明、身份證正反面、侵權鏈接),站長將在收到郵件24小時內刪除。