新智元推薦

編輯:SF

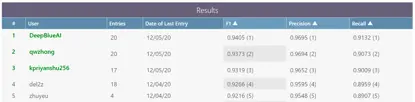

2月2-9日,AAAI 2021於線上隆重召開。AAAI(美國人工智能協會)作為人工智能領域的主要學術組織之一,其主辦的年會被列為國際人工智能領域的 A 類頂級會議。來自中國的DeepBlueAI團隊首次參加AAAI挑戰賽,便在Acronym Disambiguation(首字母縮寫詞消歧)賽道中與阿裡巴巴等知名機構同臺競技,並獲得冠軍。

團隊成績

任務介紹

首字母縮寫在許多英文文獻和文檔中,特別是在科學和醫療領域十分常見。通過使用首字母縮寫詞,人們可以避免重複使用較長的短語。

例如,“CNN”的全稱可以是“Convolutional Neural Network”,不過某些情況下它也可以是“Condensed Nearest Neighbor”的縮寫。

瞭解首字母縮寫及其全稱之間的對應關係在自然語言處理的許多任務中至關重要,如文本分類、問答系統等。

儘管使用首字母縮寫詞能夠便利人們的書寫交流,但是一個縮寫詞往往對應有多個全稱,在一些情況下,如科學或醫療領域中,一些專業名詞的縮寫可能會使得對該領域不熟悉的人在理解文意時產生一些歧義。

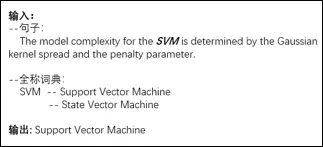

因此,如何利用計算機技術協助人們理解不同語境下縮寫詞的正確含義是值得探討的問題。首字母縮寫詞消歧任務由此而生,該任務是當給定一個首字母縮寫詞以及該詞對應的幾個可能的全稱時,根據上下文的文意,確定在當前語境中最合適的全稱。

示例如圖1所示,圖中給定了一個有語境的句子,句子中包含了一個首字母縮寫詞“SVM”,同時也提供了全稱詞典,即該縮寫詞對應的幾種全稱,分別為“Support Vector Machine”和“State Vector Machine”。

根據句意,此處輸出的SVM全稱為“Support Vector Machine”。

圖1首字母縮寫詞消歧任務示例

數據分析

針對首字母縮寫詞消歧任務,我們選用的數據集為SciAD[1]。這個數據集的標註語料為6786篇arXiv網站上的英文論文,共包含2031592個句子,句子平均長度為30個詞。該數據集的構建過程分為兩個部分。

第一部分是首字母縮寫詞對應全稱詞典的構建,對於每一個在數據集中出現的首字母縮寫詞,統計並整理其全稱,最終全稱詞典包含732個首字母縮寫詞,其中每個首字母縮寫詞平均包含3個全稱。

第二部分是標註樣本的構建,每一個樣本包含一個帶有首字母縮寫詞的句子,以及該詞在句子中的正確全稱。標註樣本共62441條。

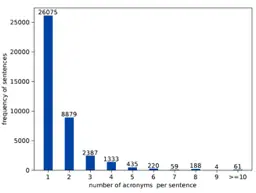

圖2展示了每一個句子中包含縮寫詞個數的分佈,分析圖2可得每一個句子中可以包含多個縮寫詞,大多數句子包含1個或者2個縮寫詞。

圖2一個句子中包含的首字母縮寫詞個數

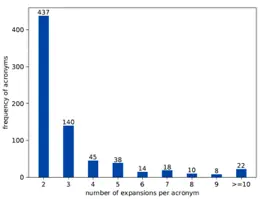

圖3展示了每個縮寫詞對應的全稱個數,由圖可得,每個縮寫詞對應包含2個或3個全稱。

圖3每個首字母縮寫詞對應的全稱個數

模型介紹

模型概述

本工作在利用預訓練模型BERT[2]的基礎上,融合了多種訓練策略,提出一種基於二分類思想的模型來解決首字母縮寫詞消歧問題。

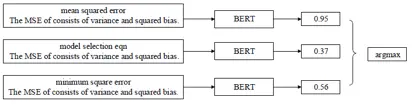

模型輸入輸出示例如圖4所示:給定包含首字母縮寫詞“MSE”的句子,將該句子結合“MSE”不同的縮寫詞全稱作為候選輸入BERT中,BERT為對一個候選進行預測,預測值最高的即為當前句子中縮寫詞對應的全稱。

圖4模型輸入輸出示例

模型輸入設定

BERT可以使用句段嵌入處理多個輸入語句,本工作將縮寫詞對應的候選全稱作為第一個輸入句段,將給定的句子作為第二個輸入句段,第一個句段的開頭用特殊符[CLS]標記,兩個句段的間隔用特殊符[SEP]標記。

此外,另添加了兩個特殊標記和來標記縮寫詞在句子中的開始和結束位置,從而使得縮寫詞能在模型訓練中獲取足夠的關注。

模型結構

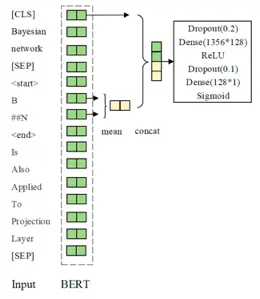

本工作模型為一個基於BERT的二分類器,具體模型結構如圖5所示。

圖5基於BERT的二分類模型

首先,根據3.1節中介紹的輸入設定,將處理好的數據輸入BERT來獲取每個token對應的嵌入表示。其次,計算首字母縮寫詞開始和結束位置的嵌入表示平均值,並將此平均值與句子開頭的[CLS]位置向量拼接。

之後,將拼接得到的向量輸入通過一個dropout層,一個前向傳播層後,通過激活函數ReLU後再輸入一個dropout層,一個前向傳播層,最後通過激活函數Sigmoid得到一個在(0,1)區間的預測值。

該值表示了此全稱為該縮寫詞在當前句子中正確全稱的可能性。

訓練策略

在上述二分類模型的基礎上,本工作融合了多種訓練策略來提升最終的模型效果。

預訓練模型的選取

基於BERT的後續相關預訓練模型層出不窮,它們利用了不同的訓練方式或不同的訓練語料。針對本任務,由於數據集SciAD的語料均為科學領域的論文,而語料的一致性對於模型性能至關重要,所以本工作在做了相應的實驗驗證後選取了在114萬篇科技論文語料上訓練的SCIBERT[3]作為基礎預訓練模型。

動態負採樣

在訓練過程中,為了確保模型能夠在更平衡的樣本上進行訓練,本工作在訓練過程中,對於每一批次(batch)輸入模型的數據進行動態負採樣,通過動態選擇固定數目的負樣本,保證了分類中負樣本在訓練中的作用,有效提高了負樣本的貢獻率,同時也有效提升了模型性能。

任務自適應預訓練

任務自適應訓練(task-adaptive pretrainin)[4]是指在第一階段通用預訓練模型的基礎上,利用任務相關文本繼續訓練,該訓練方式可以有效地提升模型性能。

針對特定任務的數據集通常是通用預訓練數據的子集,因此本工作在給定的SciAD數據集上利用掩碼語言模型(Mask Language Model)的方式進行繼續訓練以此得到新的預訓練模型。

對抗訓練

對抗訓練是一種引入噪聲的訓練方式,可以對參數進行正則化,從而提升模型的魯棒性和泛化能力。本工作採用FGM(Fast Gradient Method)[5],通過在嵌入層加入擾動,從而獲得更穩定的單詞表示形式和更通用的模型,以此提升模型效果。

偽標籤

偽標籤學習也可以稱為簡單自訓練(Simple Self-training)[6],即用有標籤的數據訓練一個分類器,然後利用此分類器對無標籤測試數據進行分類,獲取了無標籤測試數據的偽標籤,並將獲取到的預測值大於0.95的偽標籤數據與之前的訓練集混合作為新的訓練集來訓練新的模型,以此提升模型效果。

訓練流程

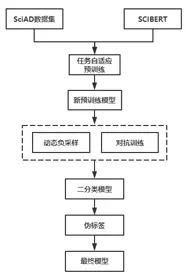

我們提出了基於BERT的二分類模型融合了多種訓練策略來提升模型效果,具體訓練流程如下圖6所示。首先,選用SCIBERT作為基礎預訓練模型,然後利用任務自適應預訓練方式得到新的預訓練模型。

在此模型上利用動態負採樣技術和對抗訓練的方式按照3.3節中的方式訓練得到二分類模型,利用該分類模型對未標註的數據集進行偽標籤判斷得到新的可以加入訓練的數據,產生新的訓練集,在新的訓練集上重複上述訓練過程得到最終的二分類模型。

圖6 訓練流程

實驗

實驗中部分參數設置如下,batch size為32,模型訓練epochs為 15,當連續3個epoch F1下降將會提前停止,BERT的初始學習率為1.0×10-5,其他參數初始學習率設置為5.0×10-4。在所有實驗中都使用Adam[7]優化器。

由於不同的預訓練模型效果不一樣為了選擇比較好的模型,我們在幾種預訓練模型上進行了實驗。表1顯示了我們在驗證集中不同預訓練模型上的實驗結果。基於scibert的模型在常用的預訓練模型中f1最好。

表1 不同預訓練模型效果表

由於scibert比其他的模型有著較大的提升,我們選取scibert作為我們的基礎模型,加上各種訓練策略的在驗證集上實驗結果如表2所示。如表所示,動態負採樣,F1分數提高了4%,提升效果比較明顯。

TAPT和對抗性訓練進一步將驗證集的性能提高了0.47%。而偽標籤在驗證集提升不大,但是在測試集上提交偽標籤效果在1-2個千分位左右。

表2 加上各種訓練策略的效果表

在驗證集集上的結果為單模型的結果,在測試集上我們選擇的交叉驗證實驗方式,並採用概率平均的方式進行模型融合,在最終的測試集上F1達到了0.9405。

總結

經過實驗發現預訓練模型的選擇對最後的效果有著巨大的影響,正如論文Don’t stop pretraining: Adapt language models to domains and tasks得出的結論,採用當前領域內的預訓練模型會比通用的預訓練模型要有很大的提升,而任務自適應預訓練也有著一定的提升,是比賽中提分的關鍵。

團隊負責人介紹

羅志鵬,DeepBlue Technology集團技術副總裁,畢業於北京大學,曾任職於微軟亞太研發集團。現主要負責公司AI平臺相關研發工作,帶領團隊已在CVPR、ICCV、ECCV、KDD、NeurIPS、SIGIR等數十個世界頂級會議挑戰賽中獲得近三十項冠軍,以一作在KDD、WWW等國際頂會上發表論文,具有多年跨領域的人工智能研究和實戰經驗。

參考文獻

1

1.Veyseh, A. P. B.; Dernoncourt, F.; Tran, Q. H.; and Nguyen,T. H. 2020b. What does this acronym mean? Introducing a new dataset for acronym identification and disambiguation. In Proceedings of the 28th International Conference on Computational Linguistics, 3285–3301.

2.Devlin, J.; Chang, M.-W.; Lee, K.; and Toutanova, K. 2018.Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv preprint arXiv:1810.04805.

3.Beltagy I, Lo K, Cohan A. SciBERT: A pretrained language model for scientific text[J]. arXiv preprint arXiv:1903.10676, 2019.

4.Gururangan, S.; Marasovi ́c, A.; Swayamdipta, S.; Lo, K.;Beltagy, I.; Downey, D.; and Smith, N. A. 2020. Don’t stop pretraining: Adapt language models to domains and tasks. In Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, 8342–8360. Online: Association for Computational Linguistics.

5.Miyato, T.; Dai, A. M.; and Goodfellow, I. 2017. Adversarial training methods for semi-supervised text classification. In Proceedings of International Conference on Learning Representations.

6.Iscen, A.; Tolias, G.; Avrithis, Y.; and Chum, O. 2019. Label propagation for deep semi-supervised learning. In Proceedings of the IEEE conference on computer vision and pattern recognition, 5070–5079.

7.Kingma D P, Ba J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv:1412.6980, 2014.

轉載請超鏈接註明:頭條資訊 » AAAI 2021|首字母縮寫詞消歧挑戰賽冠軍技術分享

免責聲明

:非本網註明原創的信息,皆為程序自動獲取互聯網,目的在於傳遞更多信息,並不代表本網贊同其觀點和對其真實性負責;如此頁面有侵犯到您的權益,請給站長發送郵件,並提供相關證明(版權證明、身份證正反面、侵權鏈接),站長將在收到郵件24小時內刪除。